[Mathematical Statistics with Applications 7th Edition, Wackerly, Mendenhall, Scheaffer]

점추정량의 성질과 여러가지 추정법

9장 키워드

효율성(efficiency), 일치성(consistency), 충분성(sufficiency), 인수분해정리(factorization criterion), 라오-블랙웰 정리(Rao-Blackwell Theorem), 적률추정법(The Method of Moments, MoM), 최대우도추정법(The method of Maximum Likelihood, MLE)

9.1 Introduction

8장에서 좋은 점추정을 하기 위해 unbiased하기를 기대했다. ($E(\hat{\theta}) = \theta$)

9장에서는 더 수식적이고 정확한 점추정을 배울 것이다. 효율성(efficiency), 일치성(consistency), 그리고 충분성(sufficiency)를 이용할 것이다. 그 결과로 충분성과 불편추정량의 관계를 서술하는 Rao-Blackwell theorem(라오-블랙웰 정리)를 배울 것이다. 일반적으로 적은 분산을 갖는 불편추정량이 충분통계량의 함수가 된다.

9.2 Relative Efficiency

상대적 효율성

같은 target parameter($\theta$)에 대한 하나 이상의 불편추정량($\hat{\theta_1}, \hat{\theta_2}$)을 얻는 경우가 많다. 8.2에서 다뤘듯이, 우리는 작은 분산을 같은 추정량을 선호한다. 즉, 두 추정량이 unbiased하다면, 더 적은 분산이 relativel;y more efficient하다고 한다.

두 불편추정량 $\hat{\theta_1}, \hat{\theta_2}$에 대하여분산이 각각 $V(\hat{\theta_1}), V(\hat{\theta_2})$라 하자. $\hat{\theta_2}$에 대한 $\hat{\theta_1}$의 상대적 효율성은 $eff(\hat{\theta_1}, \hat{\theta_2})$라 하고

$$\mathrm{eff}(\hat{\theta_1}, \hat{\theta_2}) = \cfrac{V(\hat{\theta_2})}{V(\hat{\theta_1})}$$

Example 9.1

구간 $(0. \theta)$ 에서 정의된 균등분포에서 임의로 추출된 $Y_1, Y_2, ..., Y_n$이 있다. 두 추정량에 대하여 $\textrm{eff}(\hat{\theta_1}, \hat{\theta_2})$를 구하여라

$$\hat{\theta_1} = 2\bar{Y}, \quad \textrm{and} \quad \hat{\theta_2} = \left(\cfrac{n + 1}{n}\right)Y_{(n)} where $Y_{(n)} = \textrm{max}(Y_1, Y_2, ..., Y_n)$$

균등분포이기 때문에 $\mu = \cfrac{\theta}{2}, \sigma^2 = \cfrac{\theta^2}{12}$이므로

$$E(\hat{\theta_1}) = 2E(\bar{Y}) = \theta$$

$$V(\hat{\theta_1}) = 4V(\bar{Y}) = 4\left[ \cfrac{V(Y_i)}{n} \right] = \left(\cfrac{4}{n}\right) \left(\cfrac{\theta^2}{12} \right) = \cfrac{\theta^2}{3n}$$

따라서 $\theta_1$은 unbiased estimator(불편추정량)이다

$Y_{(n)}$의 누적함수는 $F_{(n)}(y) = \left(\cfrac{y}{\theta}\right)^{n}$ 이므로 $f_{(n)}(y) = n\left( \cfrac{y^{n-1}}{\theta^{n}} \right)$이므로

$$E(Y_{(n)}) = \cfrac{n}{\theta^n}\displaystyle\int_0^{\theta}y^n dy = \left( \cfrac{n}{n+1}\right)\theta$$

$E(\hat{\theta_2})=\theta$이므로 $\hat{\theta_2}$도 불편추정량이다

$$E(Y_{(n)}^2) = \cfrac{n}{\theta^n}\displaystyle\int_0^{\theta}y^{n+1} dy = \left( \cfrac{n}{n+2}\right)\theta^2$$

$$V(Y_{(n)}) = \cfrac{\theta^2}{n(n+2}$$

따라서 상대적 효율성을 계산하면

$$\textrm{eff}(\hat{\theta_1}, \hat{\theta_2}) = \cfrac{3}{n+2}$$

이는 $n > 1$인 경우에 $\theta_2$가 더 적은 분산이기 때문에 $\theta_2$가 더 preferable하다.

9.3 Consistency

일치성

추정량 $\hat{\theta_n}$은 양수 $\epsilon$에 대하여 아래를 만족할 때 $\theta$에 대한 일치추정량(consistent estimator of $\theta$)이라 한다.

$$\displaystyle\lim_{n \to \infty}P(|\hat{\theta_n} - \theta| \le \epsilon) = 1$$

$$\textrm{or}$$

$$\displaystyle\lim_{n \to \infty}P(|\hat{\theta_n} - \theta| > \epsilon) = 0$$

$\hat{\theta_n}$은 $n$개의 표본을 이용한 추정량이다. 예를 들어 $\bar{Y}_100$은 표본의 크기 $n=100$일 때 100번 관측하여 얻은 평균이다.

만약 $\hat{\theta_n}$이 불편추정량이고 $\displaystyle\lim_{n \to \infty}V($\hat{\theta_n}$) = 0$이라면 $\hat{\theta_n}$은 consistent estimator이다. (증명은 체비셰프 부등식을 이용하여 분산의 극한이 0임을 보인다.)

$\hat{\theta_n}$과 $\hat{\theta_n^{\prime}}$이 각각 $\theta_n$과 $\theta_n^{\prime}$으로 수렴할 때 다음이 성립한다. (수열의 극한의 성질과 비슷하다)

- $\hat{\theta_n} + \hat{\theta_n^{\prime}} = \theta_n + \theta_n^{\prime}$

- $\hat{\theta_n} \times \hat{\theta_n^{\prime}} = \theta_n \times \theta_n^{\prime}$

- $\hat{\theta_n} / \hat{\theta_n^{\prime}} = \theta_n / \theta_n^{\prime}$ (단, $\theta_n^{\prime} \neq 0$)

- $g$가 연속인 실수 함수일 때, $g(\hat{\theta_n})$은 $g(\theta)$로 수렴

9.4 Sufficiency

충분성

이번 장에서는 타겟 파라미터에 대한 모든 정보를 갖는 통계적 방법을 배울 것이다. 이러한 통계를 sufficiency(충분성), sufficient statistics(충분 통계량)라 부른다. 후술하겠지만, good estimatorss는 모든 sufficient statistics function이다. 게다가, 충분통계량은 모든 불편추정량 중에서 최소 분산을 갖는 추정량을 찾는데 사용될 수 있다.

성공확률이 $p$이고 시행횟수가 $n$인 이항분포에서 성공하면 $X_i = 1$, 실패하면 $X_i = 0$이라 하고 $Y = \sum_{i=1}^{n}X_i$를 생각해보자. 만약 $Y$값을 알고 있다면, $X_1, X_2, ..., X_n$을 통해 $p$에 대한 정보를 얻을 수 있을까? 한가지 방법은 $Y$가 주어졌을 때 $X_1, X_2, ..., X_n$의 조건부분포(conditional distribution)를 살펴보는 것이다.

$$P(X_1=x_1, ..., X_n=x_n | Y = y) = \cfrac{P(X_1=x_1, ..., X_n=x_n, Y=y)}{P(Y=y)}$$

우변의 분자는 $\sum_{i=1}^nx_i \neq y$일 때 $0$이다. 만약 $\sum_{i=1}^nx_i =y$라면 $1$의 개수는 $y$이고 $0$의 개수는 $n-y$이다. 우변의 분모는 정확히 $y$번의 성공이다. 따라서

$$P(X_1=x_1, ..., X_n=x_n | Y = y) = \cfrac{p^{y}q^{n-y}}{\binom{n}{y}p^{y}q^{n-y}} = \cfrac{1}{\binom{n}{y}}, \quad \textrm{if} \sum_{i=1}^{n}x_i = y$$

이를 통해 $X_1, X_2, ..., X_n$은 $p$에 의존적이지 않다는 것을 알 수 있다. 즉, $Y$를 안다면, $X_1, X_2, ..., X_n$는 $p$값을 추가적으로 정보를 제공하지 않는다. 이런 의미에서 $Y$는 $p$에 대해 충분성을 갖고 있다고 한다.

이를 일반화하면 다음과 같다.

$Y_1, Y_2, ..., Y_n$은 알지 못하는 모수 $\theta$를 갖는 확률분포의 확률변수라 하자. 어떤 통계량 $U = g(Y_1, Y_2, ..., Y_n)$은, $Y_1, Y_2, ..., Y_n$의 조건부 분포가 $\theta$에 의존적이지 않을 때, $\theta$에 대해 충분하다고 한다(sufficient)

이전에 pmf/pdf는 $p(y), f(y)$와 같이 $y$에 대해서만 식을 작성했다. 이제부터는 확률변수 $Y$가 모수 $\theta$에 의존할 경우에는 pmf/pdf를 $p(y|\theta), f(y|\theta)$로 표기할 것이다. 결합분포의 경우에는 $p(y_1, y_2, ..., y_n|\theta), f(y_1, y_2, ..., y_n|\theta)$로 표기한다.

모수 $\theta$ 의존적인 확률변수 $Y_1, Y_2, ..., Y_n$들의 관측값을 $y_1, y_2, ..., y_n$이라 하자. 이때 표본의 가능도 $L(y_1, y_2, ..., y_n|\theta)$는 $y_1, y_2, ..., y_n$의 결합분포로 정의된다.

p.m.f의 경우 $L(y_1, y_2, ..., y_n|\theta) = p(y_1, y_2, ..., y_n|\theta) = p(y_1|\theta) \times p(y_2|\theta) \times \dots \times p(y_n|\theta)$

p.d.f의 경우 $L(y_1, y_2, ..., y_n|\theta) = f(y_1, y_2, ..., y_n|\theta) = f(y_1|\theta) \times f(y_2|\theta) \times \dots \times f(y_n|\theta)$

간단히 표기할 때는 $L(y_1, y_2, ..., y_n|\theta)$ 대신에 $L(\theta)$로 표기한다.

$U$가 확률분호 $Y_1, Y_2, ..., Y_n$의 통계량이라 하자. $U$가 충분통계량이 되기위한 필요충분조건은 $L(y_1, y_2, ..., y_n|\theta)$가 다음처럼 두개의 음이아닌 함수로 분해될 때인다.

$$L(y_1, y_2, ..., y_n|\theta) = g(u, \theta) \times h(y_1, y_2, ..., y_n)$$

단, $g(u, \theta)$는 $u, \theta$만을 인자로 갖고, $h(y_1, y_2, ..., y_n)$는 $\theta$에 대한 식이 아니어야 한다.

Example 9.5

$Y_1, Y_2, ..., Y_n$을 아래와 같은 확률밀도함수의 확률변수라고 하자

$$f(y_i|\theta) = (1/\theta)e^{-y_1 / \theta}, \quad 0 \le y_i < \infty, \textrm{where} \theta > 0, i = 1, 2, ..., n $$

이 때 $\bar{Y}$가 모수 $\theta$의 충분통계량임을 보여라.

결합밀도의 가능도는

$L(y_1, y_2, ..., y_n|\theta) = f(y_1, y_2, ..., y_n|\theta) = f(y_1|\theta) \times f(y_2|\theta) \times \dots \times f(y_n|\theta)=\cfrac{e^{y_1/\theta}}{\theta} \times \cfrac{e^{y_2/\theta}}{\theta} \times \dots \times \cfrac{e^{y_n/\theta}}{\theta} = \cfrac{e^{-n\bar{y}}/\theta}{\theta^n}$

$g(\bar{y}, \theta) = \cfrac{e^{-n\bar{y}}/\theta}{\theta^n}, \quad h(y_1, y_2, ..., y_n) = 1$을 만족하므로 $\bar{Y}$는 $\theta$의 충분통계량이다.

9.5 The Rao-Blackwell Theorem and Minimum-Variance Unbiased Estimation

라오-블랙웰 정리와 최소분산불편추정량(MVUE)

라오-블랙웰 정리

$\hat{\theta}$가 $\theta$에 대한 불편추정량이고 $(\hat{\theta}) < \infty$라 하자. 만일 $U$가 $\theta$에 대해 충분통계량이라면 $\hat{\theta}^{*} = E(\hat{\theta}|U)$로 정의한다. 그리고 모든 $\theta$에 대하여 아래가 성립한다.

$$E(\hat{\theta^{*}}) = \theta \quad \textrm{and} \quad V(\hat{\theta^{*}}) \le V(\hat{\theta})$$

(증명)

$$E(\hat{\theta^{*}}) = E[E(\hat{\theta} | U)] = E(\hat{\theta}) = \theta$$

이므로 $\hat{\theta^{*}}$는 $\theta$의 불편추정량이다.

$$V(\hat{\theta}) = V(E[\hat{\theta} | U]) + E[\hat{\theta} | U] = V(\hat{\theta^{*}}) + E[\hat{\theta} | U]$$

이므로 $V(\hat{\theta}) \ge V(\hat{\theta^{*}})$를 만족한다.

이를 해석하면, 불편추정량 $\hat{\theta}$와 충분통계량 $U$가 있을 때, 조건부 기댓값 $E(\hat{\theta}|U)$을 취한 $\hat{\theta^{*}}$의 분산은 원래 불편추정량의 분산 이하의 값을 갖는다는 뜻이다.

다시말하면, 불편추정량과 충분통계량을 가지고 MVUE를 도출할 수 있다는 것이다.

Example 9.6

$Y_1, Y_2, ..., Y_n$을 $P(Y_i=1) = p, \textrm{and} P(Y_i=0)=1-p$인 분포에서 추출된 확률변수라 하자. (베르누이변수라고 하자.) factorization criterion을 이용하여 충분통계량을 구하라. 그리고 $p$의 MVUE를 구하여라.

$$P(Y_i = y_i) = p^{y_i}q^{1-y_i} (q = 1 - p), \quad y_i = 0, 1$$

이므로 가능도를 구하면

$L(y_1, y_2, ..., y_n|p) = p^{y_1 + y_2 + ... + y_n}q^{n - (y_1 + y_2 + ... y_n)} = p^{\sum y_i}q^{n - \sum y_i} \times 1$

$U = \sum_{i=1}^{n}Y_i$은 $p$에 대한 충분통계량이다. 그리고 $E(U)=np$ 즉 $E(U/n) = p$이므로 $U/n = \bar{Y}$는 $p$에 대한 불편추정량이다. 그리고 $U$가 충분통계량이기 때문에 추정량 $\hat{p}=\hat{Y}$는 MVUE이다.

Example 9.7

$Y_1, Y_2, ..., Y_n$을 아래와 같은 Weibull 밀도 함수의 확률변수라 하자.

$$f(y | \theta) = \left( \cfrac{2y}{\theta}\right) e^{-y^2/\theta} , \quad y > 0$$

이때 $\theta$의 MVUE를 구하여라.

가능도함수를 구하면

$$L(y_1, y_2, ..., y_n) = \left(\cfrac{2}{\theta}\right)^{n} \textrm{exp} \left( -\cfrac{1}{\theta} \displaystyle \sum_{i=1}^{n}y_i^2 \right) \times \displaystyle\prod_{i=1}^{n}y_i$$

$\times$를 기준으로 왼쪽이 $g(\sum y_i^2, \theta)$, 오른쪽이 $h(y_1, y_2, ..., y_n)$이므로 $U = \sum_{i=1}^{n}Y_i^2$은 충분통계량이다. 그리고 계산의 편의를 위해 $W = Y_i^2$이라 하면

$$f_{W}(w) = F^{\prime}(\sqrt{w})= f(\sqrt{w}) \cfrac{d(\sqrt{w})}{dw} = \left( \cfrac{1}{\theta} \right) e^{-w/\theta}$$

즉 $Y_i^2$은 지수분포를 따르는 확률변수임을 알 수 있다. 또한

$$E(Y_i^2) = E(W) = \theta, \quad \textrm{and} \quad E\left( \displaystyle \sum_{i=1}^{n}Y_i^2 \right) = n\theta$$

이므로 $\hat{\theta} = \cfrac{1}{n}\displaystyle\sum_{i=1}^{n}Y_i^2$는 $\theta$에 대한 불편추정량이자 충분통계량이다. 따라서 $\hat{\theta} = \cfrac{1}{n}\displaystyle\sum_{i=1}^{n}Y_i^2$는 $\theta$의 MVUE이다.

Example 9.8

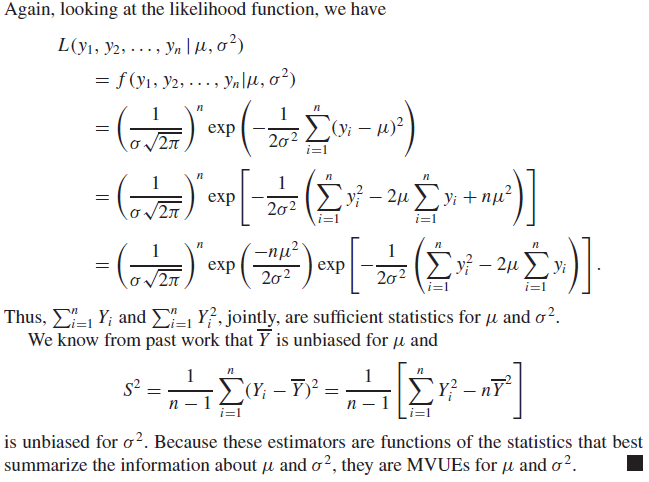

$Y_1, Y_2, ..., Y_n$을 미지수인 평균과 분산이 $\mu, \sigma^2$인 정규분포의 확률변수라 하자. 이때 $\mu, \sigma^2$의 MVUE를 구하시오.

Example 9.9

$Y_1, Y_2, ..., Y_n$을 아래 지수분포에서 추출된 확률변수라 하자.

$$f(y | \theta) = \left( \cfrac{1}{\theta} \right) e^{-y/\theta}$$

이때 $V(Y_i)$의 MVUE를 구하시오.

$L(y_1, y_2, ..., y_n | \theta) = \Pi_{i=1}^{n}f(y_i | \theta) = \cfrac{1}{\theta^n}e^{-\sum_{i=1}^{n}y_i / \theta} \times 1$

이므로 $\sum_{i=1}^{n}y_i$는 충분통계량이다. 따라서 $\bar{Y}$는 MVUE이다.

$E(Y_i) = \theta, V(Y_i) = \theta^2$이므로 $\bar{Y}^2$을 $\theta^2$의 추정량으로 사용하고 싶을 것이다. 그러나

$$E(\bar{Y}^2) = V(\bar{Y}) + [E(\bar{Y})]^2 = \left( \cfrac{n+1}{n} \right) \theta^2$$

이므로 불편추정량이 아니다. 이를 보정하려면 $\left( \cfrac{n}{n+1}\right) \bar{Y}^2 $을 $\theta^2$의 MVUE이다. 그리고 이보다 더 적은 분산을 갖는 추정량은 없다.

Example 9.10

아래 데이터는 미사일 유도 조작 시스템에서 작동되는 동일한 10개의 전자장비의 수명에 대한 데이터이다.

$$0.637, 1.531, 0.733, 2.256, 2.364, 1.601, 0.152, 1.826, 1.868, 1.126$$

장비의 수명은 Weibull 분포를 따른다.

$$f(y | \theta) = \left( \cfrac{2y}{\theta} e^{-y^2 / \theta} \right), \quad y > 0$$

주어진 데이터를 이용하여 95%의 신뢰도를 갖는 $\theta$의 신뢰구간을 구하시오.

$L(y_1, y_2, ..., y_n | \theta) = \left( \cfrac{2}{\theta} \right)^{n} \textrm{exp}\left( -\cfrac{1}{\theta}\sum_{i=1}^{n}y_i^2 \right) \times (y_1y_2\times \dots \times y_n)$

이므로 충분통계량은 $\sum_{i=1}^{n}Y_i^2$ 이다.

$W_i = Y_i^2$이라 하면 $f_W(w) = f(\sqrt{w}) \cfrac{d}{dw}(\sqrt{w}) = \cfrac{1}{\theta}e^{-w / \theta}$, 이고

$T_i = \cfrac{2W_i}{\theta}$라 하면 $f_T(t) = f_W(\cfrac{\theta}{2}t) \cfrac{d}{dt}\left( \cfrac{\theta}{2}t \right) = \cfrac{1}{2}e^{-t / 2}$ 이다.

따라서 $T_i$는 자유도가 $2$인 $\chi^2$ 분포를 따른다. 그리고 $Y_i$가 독립이므로 $T_i$도 독립이다. 이를 확장하면

$$\sum_{i=1}^{10}T_i = \cfrac{2}{\theta}\sum_{i=1}^{10}Y_i^2$$

은 자유도가 20인 카이제곱 분포를 따른다.

카이제곱분포표를 이용하면 $P(a \le \cfrac{2}{\theta}\sum_{i=1}^{10}Y_i^2 \le b) = 0.95$를 만족하는 $a, b$는 각각 9.591, 34.170이다. 식을 변형하면 $P(\cfrac{2\sum_{i=10}^{10}Y_i^2}{b} \le \theta \le \cfrac{2\sum_{i=10}^{10}Y_i^2}{a}) = 0.95$ 이고 $a=9.591, b=34.170, \sum_{i=1}^{10}Y_i^2 = 24.643$를 대입하면 신뢰구간은 $(1.442, 5.139)$이다.

신뢰구간의 길이가 꽤 길지만, 단지 10개의 표본만 이용했을 뿐이다. (더 많은 데이터가 있다면 유의미하게 좁아진다는 뜻)

9.5를 요약

- 라오-블랙웰 정리를 이용하여 적은 분산을 갖는 불편추정량은 충분통계량의 함수임을 알 수 있다.

- factorization criterion을 이용하여 충분통계량을 찾을 수 있다.

- MVUE는 다음과 같은 절차로 찾는다.

- 가장 좋은 충분통계량 $U$를 결정한다.

- $E[h(U)] = \theta$를 만족하는 함수 $h(U)$를 찾는다.

대부분의 경우 MVUE를 적용할 수 있다. 그러나 가끔 가장 좋은 충분통계량(best sufficient statistics)는 매우 복잡한 경우가 있다. 그리고 이런 경우와 비슷하게, 불편추정량을 찾기 어려울 수도 있다. 이 2가지 이유로, 불편추정량을 찾는 2가지 방법(적률추정법-the method of moments, 최대우도추정법-the method of maximum likelihood)을 소개할 것이다. 3번째 중요한 방법은 최소제곱법(the mothod of least squares)가 있으며 이는 11장에서 다룰 것이다.

9.6 The Method of Moments

적률법, 적률을 이용한 점추정 방법

적률을 이요한 점추정은 전통적인 점추정 방법 중 하나이다. 더 정교한 방법은 9.7에서 배울 최대우도추정법이라는 것이 있다.

적률법은 아주 간단한 과정을 통해 하나 이상의 모수를 추정할 수 있다. $k$번째 적률을 $\mu^{\prime}_{k} = E(Y^k)$임을 떠올리자. 그렇다면 $k$번째 표본적률은 다음과 같다.

$$m^{\prime}_k = \cfrac{1}{n}\sum_{i=1}^{n}Y_i^k$$

적률법은 표본적률은 모수의 적률에 대응되는 좋은 추정량을 제공할 것이라는 직관에서 기인한다.

[적률추정법]

$t$개의 모수에 대하여 $t$개의 방정식 $\mu^{\prime}_k = m^{\prime}_k$ for $k=1, 2, ..., t.$의 해로부터 추정량을 구한다.

Example 9.11

미지수 $\theta$에 대하여, 구간 $(0, \theta)$에서 정의된 균등분포에서 $n$개 추출된 관측값들을 $Y_1, Y_2, ..., Y_n$이라 하자. 적률추정법을 이용하여 $\theta$를 추정하여라.

균등분포이기 때문에 $\mu^{\prime}_1 = \mu = \cfrac{\theta}{2}$ 이고 1차 표본적률 $m^{\prime}_1$은

$$m^{\prime}_1 = \cfrac{1}{n}\sum_{i=1}^{n}Y_i = \bar{Y}$$

이다. 따라서 우리는 $\mu^{\prime}_1 = \cfrac{\theta}{2} = \bar{Y}$ 에서 $\theta$의 추정량은 $\hat{\theta} = 2\bar{Y}$이다.

Example 9.12

예제 9.11에서 보인 추정량 $\hat{\theta} = 2\bar{Y}$가 일치성(consistent)을 가짐을 보여라.

$\hat{\theta} = 2\bar{Y}$는 불편추정량임을 알 수 있다. 그리고 $V(\hat{\theta}) = \cfrac{\theta^2}{3n}$이고 $\displaystyle\lim_{n \to \infty}V(\hat{\theta}) = 0$이므로 위에서 구한 추정량은 일치성을 갖는다.

예제 9.11과 9.12에도 불구하고 factorization criterion은 $Y_{(n)} = \textrm{max}(Y_1, Y_2, ..., Y_n)$이 가장 좋은 충분통계량임이다. 라오-블랙웰 정리에 따르면, 적률추정법으로 얻은 추정량은 큰 분산을 가질 것이다.

9.7 The Method of Maximum Likelihood

최대우도법, 최대우도추정법, MLE

우도(likelihood)가 최대가 되는 모수를 찾는 방법이다.

Example 9.14

$n$번 시행하는 이항분보의 관찰값을 $y_1, y_2, ..., y_n$이라 하고, 성공하면 $y_i=1$, 실패하면 $y_i=0$이라 하자. 이때 확률 $p$의 MLE를 구하시오.

$$L(p) = L(y_1, y_2, ..., y_n | p) = p^{y}(1-p)^{n-y}, \quad \textrm{where} \quad y = \sum_{i=1}^{n}y_i$$

$L(p)$의 최댓값을 찾는 방법은 $p$에 대하여 미분하여 미분값이 $0$이 되는 $p$를 찾는 것이다. 그리고 로그함수 또한 증가함수이기 때문에 계산이 간단해진다.

$$\ln{[L(p)]} = y\ln{p} + (n - y)\ln{1 - p}$$

$$\cfrac{d \ln{L(p)}}{dp} = \cfrac{y}{p} - \cfrac{n - y}{1 - p}$$

따라서 $\cfrac{y}{\hat{p}} - \cfrac{n - y}{1 - \hat{p}} = 0$이 되는 $\hat{p}$를 구하면 $\hat{p} = \cfrac{y}{n}$ 즉 표본비율과 동일하다.

Example 9.15

평균과 분산이 각각 $\mu, \sigma^2$인 정규분포에서 $n$개의 표본을 추출하고, 그 확률변수들을 $Y_1, Y_2, ..., Y_n$이라 하자. 이때 $\mu, \sigma^2$의 MLE를 구하여라.

$L(\mu, \sigma^2) = f(y_1, y_2, ..., y_n | \mu, \sigma^2) = \displaystyle\Pi_{i=1}^{n}f(y_i | \mu, \sigma^2) = \left(\cfrac{1}{2\pi\sigma^2}\right)^{n/2} \textrm{exp}\left[ \cfrac{-1}{2\sigma^2}\sum_{i=1}^{n}(y_i - \mu)^2 \right]$

$$\ln{L(\mu, \sigma^2)} = -\cfrac{n}{2}\ln{(\sigma^2)} -\cfrac{n}{2}\ln{(2\pi)} - \cfrac{1}{2\sigma^2}\sum_{i=1}^{n}(y_i - \mu)^2$$

$\mu$에 대해 편미분하면

$$\cfrac{\partial\{\ln[L(\mu, \sigma^2)]\}}{\partial{\mu}} = \cfrac{1}{\sigma^2}\sum_{i=1}^{n}(y_i - \mu)$$

$\sigma^2$에 대해 편미분하면 ($\sigma^2$이 하나의 상수이다. 헷갈리면 $v$로 치환해서 풀자)

$$\cfrac{\partial\{\ln[L(\mu, \sigma^2)]\}}{\partial{\sigma^2}} = -\cfrac{n}{2\sigma^2} + \cfrac{1}{2\sigma^4}\sum_{i=1}^{n}(y_i - \mu)^2$$

따라서 각 편미분값이 $0$이 되는 $\mu, \sigma^2$의 값을 $\hat{\mu}, \hat{\sigma^2}$이라 하면

$$\cfrac{1}{\hat{\sigma^2}}\sum_{i=1}^{n}(y_i - \hat{\mu})^2 = 0, \quad \textrm{or} \sum_{i=1}^{n}y_i -n\hat{\mu} = 0, \quad \textrm{and} $$

$\hat{\mu} = \cfrac{1}{n}\sum_{i=1}^{n}y_i = \bar{y}$ (즉, 표본평균과 같다)

따라서 $\hat{\sigma^2} = \cfrac{1}{n}\sum_{i=1}^{n}(y_i - \bar{y})^2$

Example 9.16

구간 $(0, \theta), \theta > 0$에서 정의된 균등분포 $f(y_i | \theta) = 1 / \theta$ 에서 $n$개를 추출한 확률변수 $Y_1, Y_2, ..., Y_n$ 가 있다고 하자. 이때 MLE를 구하시오.

$L(\theta) = \cfrac{1}{\theta^n}$ 이고 $\theta$가 양수이므로 $L(\theta)$는 감소함수이다. 즉 $\theta$가 가장 작아야 한다.

한편 $Y_i$의 범위는 $0 \le Y_{min} \le Y_{max} \le \theta$에서 $\theta$의 범위는 $\theta \ge Y_{max}$이다. 따라서

$\hat{\theta} = \textrm{max}(Y_1, Y_2, ..., Y_n)$이다.

MLE는 항상 표본 관찰(sample observation)에 의존하게 된다. 이를 수식으로 표현하면

$$L(\theta) = L(y_1, y_2, ..., y_n | \theta) = g(u, \theta)h(y_1, y_2, ..., y_n)$$

$$\ln{[L(\theta)]} = \ln{[g(u, \theta)]} + \ln{[h(y_1, y_2, ..., y_n)]}$$

$L(\theta)$를 최대화하는데는 $h$는 어떠한 영향도 주지 않는 것을 알 수 있다. 즉 $ln{[g(u, \theta)]}$가 충분통계량 $U$에 의존하기 때문에 $\theta$의 MLE는 항상 $U$의 함수이다.

결과적으로 만약 MLE가 unbiased하다면, 추정량은 MVUE가 된다.

일반적으로, $\theta$가 어떤 분포와 연관되어있다면, 우리는 $\theta$보다는 추정 함수($t(\theta)$)에 더 관심을 갖는다. 만약 $t(\theta)$가 $\theta$에 대한 일대일 함수(단사함수, one-to-one function)이고, $\hat{\theta}$가 $\theta$의 MLE라면 $$\widehat{t(\theta)} = t(\hat{\theta})$$를 만족한다. 이를 최대우도추정량의 불변성(Invariance property of MLE)라 하고 심지어 일대일함수가 아니어도 된다.

Example 9.17

9.14에서 이항분포의 MLE는 $\hat{p} = Y/n$임을 알았다. 그렇다면 $Y$의 분산의 MLE는 무엇인가?

최대우도추정량의 불변성에 의해 $\widehat{V(Y)} = t(\hat{p}) = n\left( \cfrac{Y}{n} \right) \left(1 - \cfrac{Y}{n}\right)$ 이고 이는 불편추정량이 아니다.

Exercise 9.80

$Y_1, Y_2, ..., Y_n$은 평균이 $\lambda$인 포아송 분포에서 추출된 확률변수라고 한다.

$\textbf{a} \quad \textrm{MLE}\hat{\lambda}$를 구하여라.

$p(y | \lambda) = \cfrac{\lambda^{y} e^{\lambda}}{y!}$ 이기 때문에

$$L(y_1, y_2, ..., y_n | \lambda) = f(y_1, y_2, ..., y_n | \lambda) = \Pi_{i=1}^{n}\cfrac{\lambda^{y_i} e^{-\lambda}}{y_i !}$$

log-likelihood($l(y_1, y_2, ..., y_n | \lambda)$)를 구하면

$$l(y_1, y_2, ..., y_n | \lambda) = \ln{\Pi_{i=1}^{n}\cfrac{\lambda^{y_i} e^{-\lambda}}{y_i !}}$$

$$l(y_1, y_2, ..., y_n | \lambda) = \sum_{i=1}^{n}\ln{\cfrac{\lambda^{y_i} e^{-\lambda}}{y_i !}}$$

$$l(y_1, y_2, ..., y_n | \lambda) = \sum_{i=1}^{n}[\ln{\lambda^{y_i}} + \ln{e^{-\lambda}} - \ln{y_i !}]$$

$$l(y_1, y_2, ..., y_n | \lambda) = -n\lambda + \ln{\lambda}\sum_{i=1}^{n}y_i - \sum_{i=1}^{n}y_i!$$

$\lambda$에 대하여 미분하면

$$\cfrac{d}{d \lambda}l(y_1, y_2, ..., y_n | \lambda) = -n + \cfrac{1}{\lambda}\sum_{i=1}^{n}y_i$$

위 식이 $0$이 되게 하는 $\lambda$를 $\hat{\lambda}$라 하면

$$\hat{\lambda} = \cfrac{1}{n}\sum_{i=1}^{n}y_i = \bar{Y}$$

$\textbf{b}$ $\hat{\lambda}$의 평균과 분산을 구하여라

$E(\hat{\lambda}) = E(\bar{Y}) = E[\cfrac{1}{n} \sum_{i=1}^{n}y_i] = \cfrac{1}{n}n\lambda = \lambda$

$V(\hat{\lambda}) = V(\bar{Y}) = V[\cfrac{1}{n} \sum_{i=1}^{n}y_i] = \cfrac{1}{n^2}V[sum_{i=1}^{n}y_i] = \cfrac{1}{n^2}n\lambda = \cfrac{\lambda}{n}$

$\textbf{c}$ (a)에서 구한 추정량이 $\lambda$에 대해 consistent 함을 보여라(일치성을 보여라)

(b)에서 $\lambda$가 unbiased함을 보였고, $n$이 증가함에 따라 분산이 $0$이 되므로 consistent하다.

$\textbf{d}$ $P(Y=0)$일 때의 MLE는?

$P(Y = 0) = e^{-\lambda}$이고, Invariance property of MLE에 따라 $e^{-\hat{\lambda}}$와 같다.

참고: 적률추정법과 최대우도추정법의 차이점과 언제 써야할까?

https://trivia-starage.tistory.com/245

Method of Moments vs Maximum Likelihood Estimate (MOM, MLE, 적률추정법, 최대우도추정법)

Method of Moments & Maximum Likelihood Estimate간단하게 적률추정법(MOM)과 최대우도추정법(MLE)를 설명하고 비교해보자.Notation공통되는 notation 정리$\theta$: parameter, 모수. 일반적으로 알 수 없다(unknown). $\mu, \

trivia-starage.tistory.com

9.8 Some Large-Sample Properties of Maximum-Likelihood Estimators(Optional)

생략

9.9 Summary

9장은 8장에서 시작된 추정을 더 확장해보았다. 좋은 추정량은 consistent 하고 efficient 해야 한다. 가장 효율적인 추정량은 가장 작은 분산을 갖는 것이다 - 충분통계량의 함수.

추정량을 찾는 두 가지 방법-적률추정법, 최대우도추정법-도 배웠다. 적률추정량은 consistent하지만 대부분의 경우 efficient하지 않다.(일치성을 갖지만 효율성이 떨어진다). 반대로 MLE는 consistent하고, unbiased하다면 대부분MVUE를 도출한다. 그리고 좋은 property들이 있기 때문에 MLE를 자주 사용한다.

'스터디 > 확률과 통계' 카테고리의 다른 글

| [확률] 베이즈 정리 (Bayes' theorem) (0) | 2023.02.18 |

|---|---|

| Chapter 10. Hypothesis Testing (0) | 2022.08.24 |

| Chapter 8. Estimation (0) | 2022.08.05 |

| Chapter 4. Continuous Variables and Their Probability Distributions (0) | 2022.07.30 |

| Chapter 3. Discrete Random Variables and Their Probability Distributions (0) | 2022.07.30 |